网络爬虫也叫网络蜘蛛,是一种自动获取网页内容的程序,爬虫抓取的网页将会被搜索引擎系统储存,进行一定的分析、过滤,并建立索引,以便之后的用户能够查询到这个页面。这个获取信息的程序就是爬虫。

爬虫为搜索引擎收集内容,搜索引擎展示的内容大部分是爬虫收集的。

那么网络爬虫是怎么工作的呢?(网络爬虫基本原理)

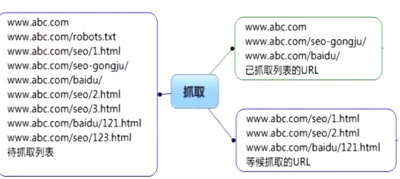

爬虫通过漫游的形式进行抓取,爬虫爬到一个页面后,看到一个链接,然后顺着那个链接又爬到另外一个页面,爬虫是不停的从一个页面跳到另外一个页面的,它一边下载这个网页,一边在提到这个网页中的链接,那个页面上所有的链接都放在一个公用的“待抓取列表”里。而且爬虫有个特点,就是他在访问你网站之前,不去做判断你这个网页本身怎么样的,不对网页内容判断就抓取,但是会有优先级的划分,尽可能不抓重复的内容,尽量抓重要内容(比如网站的公共部分)。搜索引擎同时会派出多个爬虫进行多线程的抓取,所有被爬虫抓取的网页将会被系统储存,进行一定的分析、过滤(去重),并建立索引,以便之后的查询和检索。

根据搜索引擎进行分类,目前有百度爬虫 Baiduspider 百度蜘蛛 谷歌爬虫 Googlebot

爬虫下载链接后进行提取如下:

评论